Windows Server の記憶域スペースは、記憶域インフラストラクチャを効率的に管理、保護、スケーリングできる堅牢な記憶域仮想化テクノロジです。 これにより、複数の物理ドライブを 1 つの論理記憶域プールに集約でき、そこから記憶域スペースと呼ばれる仮想ディスクを作成できます。 これらの仮想ディスクは、さまざまな回復性オプションを使用してプロビジョニングでき、冗長性、フォールト トレランス、および多様なストレージ要件を満たす柔軟性を提供します。 概念的には、独立ディスクの冗長アレイ (RAID) に似ています。

この記事では、記憶域スペースを使用して、複数の物理ドライブを 1 つの論理記憶域プールに集約し、仮想ディスクを作成し、冗長性と柔軟性のために回復性オプションを選択する方法について説明します。

記憶域スペースについて

記憶域スペースは、物理記憶域ハードウェアを論理記憶域プールに抽象化し、記憶域の管理を簡素化し、管理者が記憶域リソースを動的に割り当てできるようにします。 記憶域プールが作成されたら、ワークロードの要件に合わせて調整された特定の回復性とパフォーマンス特性で構成された、このプールから仮想ディスク (記憶域スペース) を切り取ることができます。

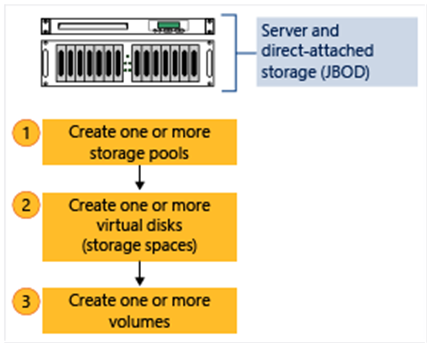

次の図は、記憶域スペースワークフローを示しています。

記憶域スペースでは、シンプル、ミラー、パリティの 3 つの主な回復性構成がサポートされています。 各種類は、パフォーマンス、容量使用率、フォールト トレランスの点で、異なる利点とトレードオフを提供します。

単純なスペース

単純なスペースは回復性や冗長性を提供しません。 データは複数のドライブにストライピングされ、パフォーマンスとストレージ容量の使用率を最大化します。 ただし、冗長性がないため、1 つのドライブで障害が発生すると、データが失われます。 単純なスペースは、データ保護が重要でない一時データ、スクラッチ ディスク、またはワークロードに適しています。

単純なスペースの主な特徴を次に示します。

- データは、高パフォーマンスのために複数のドライブにストライピングされます。

- 最大ストレージ容量使用率。

- フォールト トレランスなし。1 つのドライブで障害が発生すると、データが失われます。

- 重要でないワークロードや一時ストレージに最適です。

ミラースペース

ミラー スペースは、双方向または 3 方向ミラーリングと呼ばれる 2 つまたは 3 つのコピーにデータを複製することで冗長性を提供します。 この構成により、ドライブの障害に対するデータの可用性と保護が保証されます。 1 つのドライブで障害が発生した場合でも、他のドライブのミラー化されたコピーからデータにアクセスできます。 ミラー スペースは、読み取りと書き込みの優れたパフォーマンスを提供し、パフォーマンス重視のワークロードや重要なデータ ストレージに適しています。

ミラー スペースの主な特性を次に示します。

- 冗長性を確保するために、2 つ以上のドライブ間でデータが重複しています。

- 双方向ミラーリングでは、1 つのドライブ障害が許容されます。3 方向ミラーリングでは、2 つの同時ドライブ障害が許容されます。

- 優れた読み取りと書き込みのパフォーマンス。

- データの重複によるストレージ オーバーヘッドの増加 (双方向ミラーリングの場合は 50% オーバーヘッド、3 方向ミラーリングの場合は約 66% オーバーヘッド)。

- ミッション クリティカルなワークロード、データベース、仮想マシン ストレージに最適です。

パリティスペース

パリティスペースは、パリティ情報を複数のドライブに分散することで障害耐性を提供します。 このパリティ情報を使用すると、1 つのドライブで障害が発生した場合 (単一パリティ) または 2 台のドライブに障害が発生した場合 (デュアル パリティ)、記憶域スペースでデータを再構築できます。 パリティ スペースでは、ミラー スペースと比較して記憶域の使用率が高くなりますが、パリティ データの計算と書き込みのオーバーヘッドにより書き込みパフォーマンスが低下します。 パリティ スペースは、主に順次読み取り操作を行うアーカイブ ストレージ、バックアップ リポジトリ、ワークロードに適しています。

パリティ スペースの主な特性を次に示します。

- データは、障害隠蔽のためにパリティ情報を用いて複数のドライブに分散保存されます。

- パリティ情報を使用すると、ドライブに障害が発生した場合にデータを再構築できます。

- ミラースペースと比較して、より効率的なストレージ使用率。

- パリティ計算による書き込みパフォーマンスの低下。

- 読み取りパフォーマンスが優れ、特にシーケンシャル ワークロードの場合。

- 書き込みパフォーマンス要件が低いアーカイブ ストレージ、バックアップ、ワークロードに最適です。

ストレージバス キャッシュ

記憶域バス キャッシュは、HDD などの低速ストレージ デバイスのキャッシュ 層として、NVMe や SSD ドライブなどの高速な記憶域メディアを使用して記憶域スペースのパフォーマンスを向上させる機能です。 高速キャッシュ ドライブに頻繁にアクセスされるデータを配置することで、Storage Bus Cache は読み取りと書き込みのパフォーマンスを大幅に向上させ、待機時間を短縮し、記憶域全体の効率を最適化します。

Storage Bus Cache には、次の利点があります。

- 高速ストレージ メディアでホット データをキャッシュすることで、読み取りと書き込みの操作を高速化します。

- 混在またはランダムな I/O パターンを使用するワークロードの待機時間が短縮され、応答性が向上します。

- 広範なハードウェアアップグレードを必要とせずにストレージパフォーマンスを最適化します。

- 既存の記憶域スペースの展開とシームレスに統合され、実装と管理が簡素化されます。

仮想ディスク

記憶域スペース内の仮想ディスクは、物理記憶域リソースを論理ユニットに抽象化することで、柔軟で効率的な記憶域管理を提供します。 管理者は、1 つの記憶域プールから複数の仮想ディスクを作成できます。各仮想ディスクは、特定の回復性設定、記憶域容量、およびパフォーマンス特性を使用して個別に構成されます。 この柔軟性により、組織はワークロードの要件に合わせてストレージ ソリューションを正確に調整でき、パフォーマンスとリソース使用率の両方を最適化できます。

さらに、仮想ディスクではシン プロビジョニングがサポートされているため、事前に容量全体を事前に割り当てるのではなく、データの増加に合わせて管理者がストレージ容量を動的に割り当てることができます。 この方法により、ストレージの効率が最大化され、初期ハードウェアへの投資が削減されます。 仮想ディスクのサイズを動的に変更することもできます。これにより、管理者はダウンタイムなしでストレージ容量をシームレスに拡張でき、重要なワークロードの継続的な可用性とスケーラビリティが確保されます。

記憶域スペースとストレージスペース ダイレクトの違い

記憶域スペースと記憶域スペース ダイレクトは同様の概念を共有しますが、展開シナリオ、ハードウェア要件、スケーラビリティ、管理の複雑さが大きく異なります。 記憶域スペース は、通常、SAS を介して外部 JBOD エンクロージャに接続されたスタンドアロン サーバーまたはクラスターで使用され、コモディティ ハードウェアをサポートし、小規模な展開に適した簡単な管理を提供します。 これに対し、 記憶域スペース ダイレクト は、RDMA 対応アダプターなどの特殊なハードウェアと高速イーサネット ネットワークを介して相互接続された内部記憶域ドライブを使用して、ハイパーコンバージドクラスターまたは非集約クラスター向けに設計されているため、大規模で高性能な環境に最適です。

スケーラビリティとパフォーマンスの面では、記憶域スペースは汎用ワークロードに対して信頼性の高いパフォーマンスを提供しますが、外部ストレージ接続とドライブ数にすることができます。 ただし、記憶域スペース ダイレクトでは、SMB3 プロトコルと RDMA ネットワークを利用することで、スケーラビリティ、スループット、IOPS が大幅に向上し、仮想化、データベース、エンタープライズ アプリケーションなどの要求の厳しいワークロードに適しています。

どちらのテクノロジも回復性の構成 (単純、ミラー、パリティ) をサポートしていますが、記憶域スペース ダイレクトには、自動ドライブの交換やインテリジェントなデータ配置など、クラスター全体の回復性機能が用意されています。 記憶域スペースは、主に単一サーバーまたは外部エンクロージャ内の回復性に重点を置いています。 さらに、両方とも Storage Bus Cache を利用できるため、頻繁にアクセスされるデータをより高速なストレージ メディアにキャッシュすることでパフォーマンスが向上します。

記憶域スペース ダイレクトの詳細については、「記憶域スペース ダイレクトの概要 参照してください。

次のステップ

スタンドアロン サーバーに記憶域スペースを展開する方法について説明します。